고정 헤더 영역

상세 컨텐츠

본문

본 글은 데이터 적재를 통한 RAG 대신, 네이버 검색 API를 활용하여 네이버 검색 결과 기반으로 LLM을 사용하는 웹 데모 베이스라인 글입니다.

해당 프로젝트는 실제 사용할 수 있는 수준의 데모를 위해 Cohere API, OpenAI API, Gradio, Docker를 사용합니다.

1. 구현 컨셉

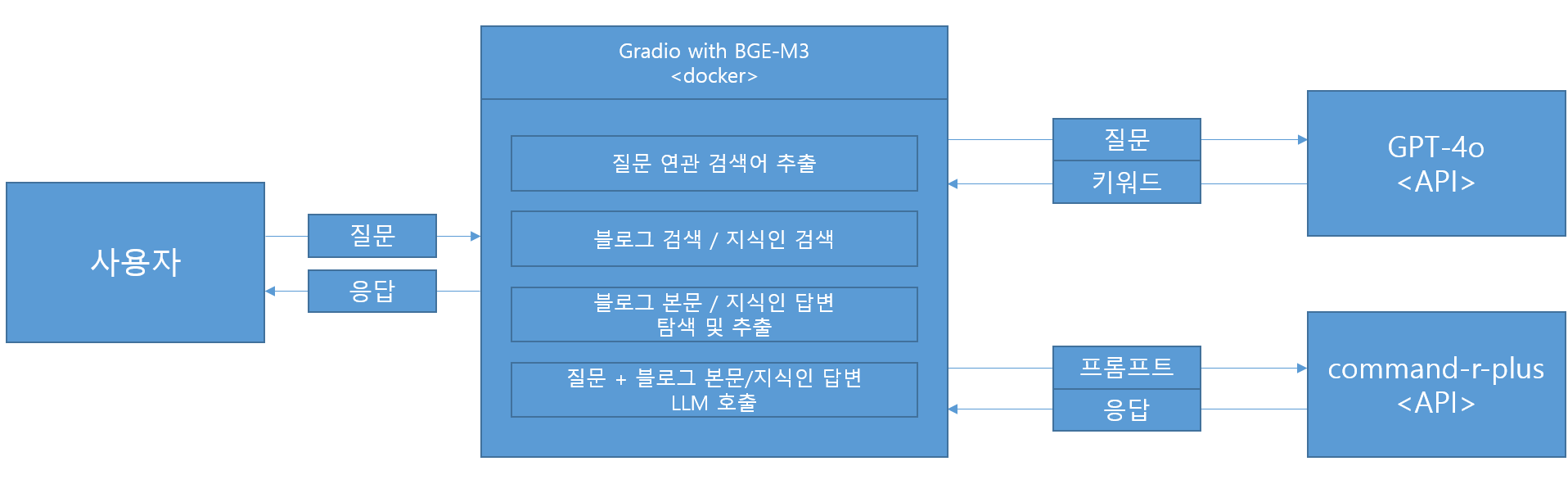

구현하고자 하는 프로젝트의 컨셉입니다. 유저의 질문을 기반으로 검색 키워드를 생성하고, 관련 블로그 / 지식인 글을 파싱합니다. 적절한 지시와 함께 질문 + 파싱된 글을 프롬프트로 사용하여 command-r-plus 모델에 입력하여 응답을 생성합니다.

이 과정에서 고려해야 할 것은 검색된 결과를 어떤 방식으로 파싱할지입니다. 네이버의 검색 시스템만 믿고 검색 결과를 사용해도 괜찮지만, rerank와 같은 방식도 고려할 수 있습니다.

2. 구현 순서

1) 블로그 검색 및 지식인 검색 크롤러 구현

- 블로그 / 지식인 본문 크롤러 구현

- 크롤링된 본문을 질문과의 유사도 기반으로 Rerank

2) API 호출 테스트

- OpenAI / Cohere API 호출 테스트

3) Gradio 서버 구축

- Gradio 서버 구축 & 웹 데모 테스트

'NLP' 카테고리의 다른 글

| LLM with Naver API - OpenAI, Cohere API 확인 & Gradio 서버 (0) | 2024.05.20 |

|---|---|

| LLM with Naver API - 크롤러 구현 (0) | 2024.05.17 |

| LLM with RAG - Gradio server (0) | 2024.05.09 |

| LLM with RAG - LLM server (0) | 2024.05.08 |

| LLM with RAG - milvus server (0) | 2024.05.07 |

댓글 영역